Cómo EVITAR que la IA use tus Datos

¿Te da miedo usar la IA por si pones… en riesgo… tus datos?

Hace un par de fines de semana tuve EL HONOR de asistir a una sesión formativa impartida por EL GRAN Y MÍTICO Jesús Alonso Gallo, pude conocerlo en persona y aprender de él.

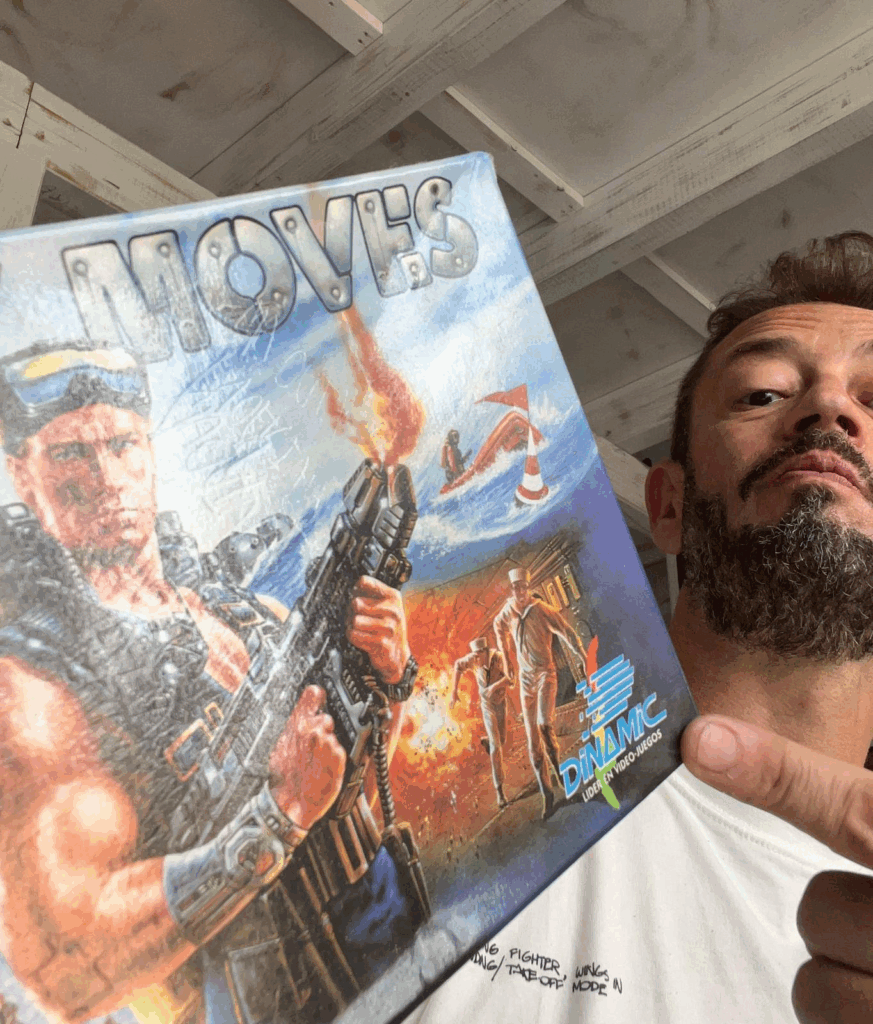

Ojo, ojo y ojo, que estamos hablando de uno de los fundadores de Restaurantes punto com y de… [un redoble de tambor aquí]… Dinamic, FX Interactive y Dinamic Multimedia (sí, sí, la que lanzó el famoso, mítico y legendario PC Fútbol).

Disfruté mucho de sus enseñanzas. Pura sabiduría. Grandes consejos.

Os recomiendo que lo sigáis en su newsletter: AQUÍ.

El caso es que durante esas jornadas, éramos un grupo reducido y cercano, salí de mi zona de confort rodeándome de gente de sectores bastante lejanos al mío.

Y qué curioso que, en esas conversaciones de café, cuando salía el tema IA, me llamaban poderosamente la atención dos cosas:

a) MIEDO a usarla («¿y si usan mis datos?»)

b) DESCONOCIMIENTO de su potencial («¿Ah, que eso se puede hacer con la IA? ¡Pero qué dices!»)

Vamos hoy con el MIEDO, que me sorprende, PEROOO hay mucho…

Fíjate cómo será la cosa, que, de hecho, la newsletter que os envié la semana pasada (en la que os contaba cómo la IA me hace el trabajo de resumir las centenares de newsletters a las que estoy suscrito) ha sido una de las que más habéis contestado.

Y la frase más común en vuestras respuestas es…

—¿No te da miedo dejarle acceso a tu correo?

Curioso…

El MIEDO a que la IA acceda a mi Gmail… que está en los servidores de una empresa llamada Google… que compite encarecidamente en el mundo de la IA… entrenando un LLM llamado Gemini…

Curioso…

El MIEDO a subir datos a una IA… mientras no parece preocuparnos subir cosas a WhatsApp, Instagram, Gmail, etc. (te dejo unos datos curiosetes y OSCUROS de todos estos al final de este correo, ya verás qué «risa»).

Recuerda una cosa: el único dato seguro en una aplicación (cualquiera, todas) es el dato que no se ha subido (y ni eso, pregúntale si no a los políticos españoles qué tal con el WhatsApp y eso).

PEROOO, al menos nosotros, sabiendo lo que hay… hagamos los deberes que están de nuestro lado.

Por eso, aquí van unas claves para protegerte cuando uses herramientas IA como ChatGPT o Claude.

Porque, diferenciemos…

Una cosa es que tus datos se usen para fines oscuros o indebidos (por error, por una política opaca o incluso por una brecha de seguridad, aquí poco puedes hacer, salvo no subir nada)…

…y otra es que se usen para entrenar modelos de IA.

Para esto último… si no quieres que pase legalmente, lo que puedes hacer es…

Desactiva el uso de tus datos para entrenar modelos

Que luego estas aplicaciones hagan uso oscuro de tus datos no está bajo nuestro control (salvo que dejemos de usarlas, que no pinta que en el futuro así sea), pero al menos, que sepamos que podemos…

En ChatGPT: ir a Configuración → Controles de datos → y desactivar «Mejorar el modelo para todos».

En Claude: ir a Settings → Privacidad → y desactivar «Permitir el uso para entrenamiento».

Pagar licencia de cuentas profesionales o empresariales

También, más si es de uso empresarial, podemos pagar un poco más.

Las licencias profesionales tienen cláusulas específicas y acuerdos legales que te garantizan que tus datos no se usarán para entrenar modelos de IA, según contrato.

Además, permiten cosas como cifrado, políticas de seguridad, cumplir normativas como GDPR, etc.

Usa modelos en local si necesitas máxima privacidad

Puedes usar alternativas open source como LLaMA o Mistral.

De hecho, en la Comunidad IA de Javier Garzás le hemos dedicado varias sesiones a esto, desde la opción de instalar LLMs «en local» o la más profesional haciendo uso de LLMs en entornos cloud controlados.

Forma al equipo

Como te conté, acabo de venir de Londres, de la IA Summit, y no puedes imaginar la de empresas que han compartido la importancia de la cultura y la formación, guías con qué se puede y qué no subir, etc.

Aun así, el Lado Oscuro es inevitable…

PEROOO… Incluso si desactivas el uso para entrenamiento o usas cifrado extremo, cuando utilizas modelos en la nube tus datos siguen pasando por servidores de terceros.

Así que el riesgo no está solo en la IA. Está en toda la cadena.

Si algo es confidencial, ni lo subas a la IA, ni lo subas a WhatsApp… PEROOO tampoco dejes drásticamente de usar la IA por MIEDO, porque te vas a quedar atrás y la IA ya es (como diría Thanos)… inevitable.

PD 1

Solo en Europa, desde la entrada en vigor del Reglamento General de Protección de Datos (RGPD) en 2018, Meta (Facebook, Instagram, WhatsApp) ha recibido seis de las diez mayores sanciones impuestas, acumulando más de 2.700 millones de euros en multas por diferentes casos relacionados con el uso indebido de datos.

Twitter fue multada con 150 millones de dólares en 2022 por facilitar datos de usuarios a anunciantes sin el consentimiento adecuado.

En 2024, X fue denunciada en nueve países europeos por el uso ilegal de datos personales de unos 60 millones de usuarios.

En 2021, Amazon fue multada con 746 millones de euros en Luxemburgo por incumplimiento de los principios generales de tratamiento de datos bajo el RGPD, siendo una de las mayores sanciones impuestas a una tecnológica en Europa.

En 2022, la Agencia Española de Protección de Datos (AEPD) impuso a Google una multa récord de 10 millones de euros por dos infracciones muy graves: ceder datos personales a terceros sin el consentimiento de los usuarios y dificultar el ejercicio del derecho al olvido.

Que la IAgilidad te acompañe.

(Por cierto, por si aún no nos conocemos, soy Javier Garzás, postdoctorado en la CMU, doctor e ingeniero en informática, llevo 25 años ayudando a managers y a equipos reales —he trabajado con +300 equipos— a mejorar su productividad y a que aporten más valor. Ahora también les ayudo a usar correctamente la IA, sin Oscuridad añadida. Y de todo lo anterior… dicen que soy el referente, en España y Latam).